Intelligence artificielle : l'erreur est-elle humaine ?

L’intelligence artificielle est régulièrement soupçonnée de commettre des erreurs... Sont-elles le reflet des erreurs humaines cachées derrière les machines ? De la recommandation de contenus sur YouTube à la justice prédictive, le jugement de l’IA a plus ou moins d’impacts dans nos vies. Ce nouvel épisode d’Au Crible de la Science, une série de podcasts réalisée avec et pour les lycéen.nes, se penche sur la question.

L’intelligence artificielle désigne les algorithmes censés simuler le fonctionnement du raisonnement humain. Source de progrès pour beaucoup, elle suscite néanmoins des inquiétudes que Jean-François Bonnefon, chercheur CNRS en psychologie cognitive au laboratoire Toulouse School of Economics Research (CNRS/Université Toulouse Capitole), et Antonin Descampe, chercheur en innovations médiatiques à l’Université catholique de Louvain, décryptent en répondant aux questions des étudiants de 1ère et 2nde année de BTS Systèmes numériques du lycée Champollion de Figeac.

Morceaux choisis

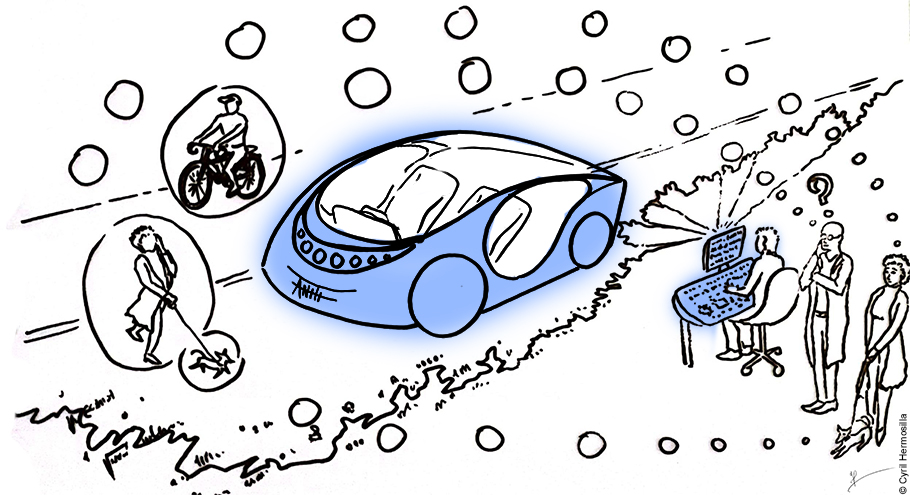

« Quand on fait une erreur pure, elle peut tomber une fois d’un côté, une fois de l’autre. C’est un peu du hasard. Ce qu’on appelle le biais, c’est quand les erreurs vont systématiquement dans une même direction. Par exemple, si une voiture autonome a 10 accident sur 1000 situations de route, mais que ces 10 accidents sont toujours avec des piétons, ça n’est pas seulement le nombre d’erreurs qui comptent, mais le type d’erreurs. On dirait qu’elle a un biais vers les accidents contre les piétons. »

« Un des exemples les plus saisissants a été le déploiement des algorithmes qui prédisent la récidive dans les tribunaux américains. Un juge a la décision de laisser ou non quelqu’un en liberté avant son procès. (…) Il y a des machines qui essaient de prédire ça. (…) Quand on regarde dans le détail le type d’erreurs qu’elles font : elles font le même nombre d’erreurs chez les prévenus noirs et chez les prévenus blancs. Mais quand elles se trompent pour les prévenus blancs, c’est plutôt une erreur indulgente : le laisser en liberté par erreur. Alors que quand elles se trompent envers un prévenu noir, c’est plutôt une erreur sévère : emprisonner par erreur. »

« Quand un humain fait une erreur, on sait qu’il y a des variations dans la performance humaine. Quand une machine fait une erreur, on a tendance à penser qu’elle est mal codée et que cette erreur va être répétée. Or, les machines peuvent avoir également des variations dans la performance. L’erreur humaine, quand elle est répétée, est complexe à corriger. Alors que lorsque la machine commet des erreurs, il est bien plus facile de les corriger. Les gens surestiment le signal qu’envoie l’erreur de la machine quant à sa compétence et sous-estiment la capacité de la machine à corriger ses biais. Cela explique notre tendance à retirer notre confiance de la machine dès lors qu’elle fait des erreurs. »

« Y-a t il des craintes infondées envers l’IA qui résultent de biais psychologiques et que l’on peut dissiper ? Oui, en donnant la possibilité aux citoyens de comprendre - non pas comment marche l’IA, c’est complexe - mais en étant transparent sur ses conséquences, négatives comme positives. Il s’agit d’aider à se construire une opinion informée sur une situation qui peut être complexe. »

Jean-François Bonnefon est chercheur en psychologie cognitive au CNRS. Il a rejoint les économistes de Toulouse School of Economics, Toulouse School of Management et l’Institute for Advanced Study. Il est titulaire de la Chaire IA moral de l’Institut interdisciplinaire d’intelligence artificielle de Toulouse, ANITI, et préside un groupe d'experts de la Commission européenne de l'éthique sur les véhicules autonomes.

« Les machines apprennent à partir des données qu’on leur soumet. Si ces données contiennent des biais statistiques, les IA vont commettre des erreurs. L’exemple de la justice prédictive est un exemple saisissant, parce qu’il s’agit d’un domaine évidement extrêmement sensible. »

« Dans les médias, on constate un déficit d’informations : il existe peu de discours nuancés sur cette question, les positions technophobes ou technophiles limitent les possibilités de débat. L’enjeu est de casser cette binarité et d’informer sur les possibilités et les écueils. »

« La transparence est fondamentale. Un citoyen lambda va vouloir a minima être informé des décisions automatiques qui ont été prises et qui ont eu un impact sur sa vie. Savoir si à un moment, une IA est intervenue dans une décision qui nous concerne. La transparence peut être aussi la transparence du code qui ne va intéresser que les personnes qui sont suffisamment expertes. C’est néanmoins un enjeu crucial : rendre ces éléments transparents favorisent un contrôle citoyen. »

Antonin Descampe est chercheur dans le domaine des innovations médiatiques à l’Université catholique de Louvain et mène des recherches au sein de l’Observatoire de recherche sur les médias et le journalisme. Il est co-responsable de l’Observatoire des pratiques socio-numériques, une plateforme du Laboratoire d'études et de recherches appliquées en sciences sociales de l’Université Toulouse 3 - Paul Sabatier.

Références conseillées par les invités

-

Moral Machine, plate-forme en ligne, développée au Massachusetts Institute of Technology, qui génère des dilemmes moraux et collecte des informations sur les décisions que les citoyens prennent entre deux résultats destructeurs.

-

La Voiture qui en savait trop : L'intelligence artificielle a-t-elle une morale ?, Jean-François Bonnefon, éditions Humensciences, 2019

-

Intelligence Artificielle, comment automatiser sans déshumaniser, une micro-conférence par Antonin Descampe, VertPop, 2021

-

Automating the news : How algorithms are rewriting the media, de N. Diakopoulos, éditions Harvard University Press, 2019 : sur la manière dont les médias sont révolutionnés par l'IA

-

Le JournalismAI festival, un événement annuel dédié à l'utilisation de l'IA dans les médias d'informations

-

The age of surveillance capitalism: The fight for a human future at the new frontier of power, S. Zuboff, 2019 : Un livre sur la manière dont nos données sont utilisées pour nous connaître mieux afin de nous influencer (et nous faire consommer)

-

Les travaux d’Antoinette Rouvroy, juriste, chercheuse au CRIDS à Namur en Belgique, sur la notion de gouvernementalité algorithmique

-

Le site de l'EU sur la régulation de l’IA, qui définit une gestion des risques de l'IA.

-

Transparents mais corruptibles: Les algorithmes au défi des comportements « adversariaux » dans le domaine journalistique, A. Descampe, A. et Standaert, F.-X., Les Cahiers du journalisme - Recherches, 2022

Consulter le dossier pédagogique de la thématique Intelligence artificielle

Le podcast Au Crible de la Science est une coproduction Exploreur Université fédérale Toulouse Midi-Pyrénées - Quai des Savoirs.

Présentation : Valérie Ravinet

Préparation : Catherine Thèves

Réalisation : Arnaud Maisonneuve

Technique : Thomas Gouazé

Production radiophonique conçue en partenariat avec le Ministère de la Culture, l'Académie de Toulouse, le CNRS et Campus FM.