Réseaux de neurones artificiels : et si le cerveau était la meilleure source d’inspiration ?

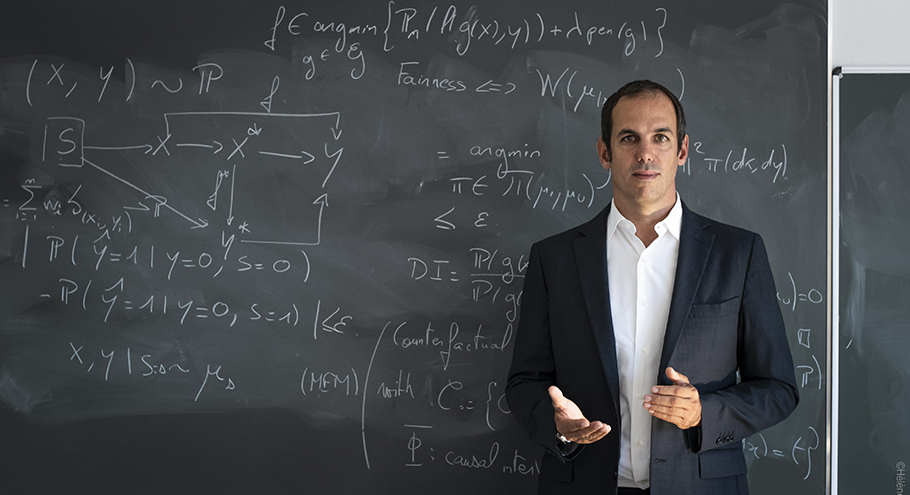

Comment nos connaissances du cerveau peuvent-elles être traduites en algorithme ? Comment améliorer les réseaux de neurones artificiels par de nouvelles architectures inspirées par le vivant ? Le chercheur Rufin VanRullen et son équipe plongent dans le cerveau humain pour inspirer l’intelligence artificielle (IA).

Par Valérie Ravinet, journaliste.

« A chaque fois qu’on atteint les limites des réseaux de neurones artificiels, on se demande comment le cerveau parvient à résoudre ces problèmes et on y cherche l’inspiration pour les améliorer »,

résume Rufin VanRullen, chercheur CNRS au Centre de Recherche Cerveau et Cognition (Cerco), titulaire de la chaire « Apprentissage profond intégrant contraintes sémantiques, cognitives et biologiques (Deep learning with semantic, cognitive and biological constraints) de l’Institut interdisciplinaire d’intelligence artificielle de Toulouse ANITI.

Intéressé par l’intelligence artificielle dès les années 90, le chercheur s’est spécialisé en neurosciences après un parcours en mathématiques et informatique. « À l’époque, la manière de percevoir l’ordinateur intelligent se réduisait à l’apprentissage de règles de raisonnement logique que la machine savait combiner ; cela me paraissait insuffisant », confie-il. « J’ai fait un long détour par les neurosciences pour étudier le fonctionnement du cerveau et comprendre comment l’ordinateur pouvait intégrer les aspects sensoriels et perceptuels pour améliorer ses capacités ». Avec l’ambition optimiste de développer une IA « forte » : faire émerger des réseaux de neurones artificiels beaucoup plus intelligents, dont les capacités sont comparables à celles des humains.

Réseaux de neurones, une technique de l’IA

Un réseau neuronal artificiel est un ensemble d’unités élémentaires de calcul qui se transmettent des signaux par l’intermédiaire de connexions, comparables aux synapses du cerveau. Le système est constitué d’algorithmes triant et effectuant des actions sur les données qui lui sont transmises. C’est l’architecture du réseau et sa connectivité qui déterminent son fonctionnement. Combien de neurones ? À quels endroits ? Quels neurones interagissent ? Avec quelle intensité ?

Avec une base d’apprentissage suffisante, certains réseaux peuvent implémenter d’eux-mêmes de nouvelles connexions entre les neurones (algorithmes de tri) voire de nouveaux neurones (algorithmes d’action). Ces réseaux font penser à l’architecture du cerveau, animal ou même humain. Cette technique, dite deep learning (ou apprentissage profond en français) est un sous-ensemble du « machine learning » ou apprentissage automatique, lui-même représentant une partie de l’IA.

« Le cerveau humain étant la forme d’intelligence la plus évoluée que l’on connaisse », le chercheur émet l’hypothèse que l’intelligence artificielle sera in fine composée uniquement de réseaux de neurones. « Cette approche prévaudra peut-être dans dix ans », estime Rufin VanRullen, puisqu’il « n’y a pas de règles dans le cerveau qui ne soient implémentées par un réseau de neurones ».

Chat, chien, ou cafetière ?

Composée de deux mathématiciens, d’un informaticien, d’une spécialiste en neurosciences, de plusieurs doctorants et post-doctorants, l’équipe pose le principe que le cerveau n’est pas contraint par les mêmes limites qu’une machine, puisque la machine se trompe parfois là où un humain ne commettrait pas d’erreur. À partir d’un état de l’art sur les réseaux de neurones artificiels, les chercheurs questionnent la robustesse de la technique et son explicabilité, c’est-à-dire la manière dont les neurones prennent les décisions. Objectif : implémenter les solutions observées dans le cerveau humain dans les réseaux de neurones. C’est ce travail que porte la chaire « Apprentissage profond intégrant contraintes sémantiques, cognitives et biologiques au sein de l’institut interdisciplinaire d’intelligence artificielle de Toulouse, ANITI.

« Prenons l’exemple de la vision artificielle », invite le chercheur. « Les réseaux de neurones reconnaissent des objets mais ne savent pas les identifier. Ils ont appris des listes de noms, savent coller des étiquettes sur les objets, sans les comprendre. Une manière de rendre les réseaux plus robustes, et donc plus performants, consiste à s’inspirer du fait que l’homme comprend ce qu’il voit, d’un point de vue sémantique. Cette reconnaissance implique que l’homme peut éventuellement confondre deux animaux, mais pas un chat et une cafetière, car ce sont deux domaines totalement différents. Pour la machine, en revanche, il n’y a pas plus de différence entre un chat et une cafetière qu’entre un chat et un chien ».

Vision et langage

L’une des approches de la chaire consiste à réunir des systèmes de vision avec des systèmes de traitement du langage, pour permettre à la machine d’accéder simultanément à l’image et au sens. « En les faisant communiquer, on peut imaginer créer des systèmes de vision plus robustes -ils continueront peut-être à confondre chien et chat, mais plus les chats avec des cafetières- et à l’inverse, on peut créer des systèmes de traitement du langage plus performants puisque lorsqu’ils traitent du langage, les réseaux de neurone artificiels ont une représentation concrète des mots ».

Autre approche : les connexions en « feed-back », ou rétroaction en français.

S’inspirant du fonctionnement du cerveau, les recherches de la chaire portent également sur le développement des connexions en feed-back (ou rétroaction en français). « Aujourd’hui, la machine apprend de l’extérieur, les informations ne circulent donc que dans une seule direction, dite feed-forward », rappelle Rufin VanRullen. Si l’on dispose de données d’apprentissage en nombre, la machine est capable de performances intéressantes, parfois surhumaines, mais elle est sensible et devient confuse quand elle ne reconnait pas la donnée. Des changements mineurs, qui pour un humain ne feraient aucune différence, peuvent être dramatiques pour le réseau de neurones artificiels. La capacité de généralisation est restreinte à son domaine d’apprentissage.

D’un point de vue applicatif, ces recherches peuvent être utiles pour anticiper des attaques dites « adversarial » (contradictoires en français). En intensifiant la robustesse des réseaux de neurone, on prévient des attaques via des stimuli qui pourraient provoquer des erreurs. Par exemple, dans un système de sécurité de reconnaissance faciale, une attaque possible serait de reconnaitre un cambrioleur comme une personne ayant droit d’entrée dans un appartement. C’est là où l’information sémantique pourrait protéger les réseaux, conjuguant reconnaissance visuelle et reconnaissance des mots.

Bio-inspiration : pour une IA rassurante

Pour Rufin VanRullen, s’inspirer du cerveau pour créer un réseau de neurones artificiel peut être vécu comme un élément non menaçant, voire rassurant, à l’heure où des craintes de voir la machine « dépasser » l’intelligence humaine surgissent. « Il est plus inquiétant de développer des IA qui ne sont pas bio inspirées », riposte-t-il. Il ajoute : « on ne comprend pas tout du fonctionnement des réseaux de neurones artificiels, comme on ne comprend pas tout du fonctionnement du cerveau humain, non plus. Ce n’est pas grave. Le débat serait plutôt de se demander pourquoi on remet en question une décision prise par une IA, qui n’est pas opaque puisqu’on a accès à toutes ses composantes (même si on ne décode pas toutes les connexions possibles) alors que la prise de décision trouve toujours sa justification chez l’homme. Pourtant, l’homme peut mentir, pas l’IA ! ».

CERCO : Centre de Recherche Cerveau et Cognition (CNRS et Université Toulouse III - Paul Sabatier). L’une des unités de recherche de l’Institut des "Sciences du Cerveau de Toulouse"

ANITI : Artificial and Natural Intelligence Toulouse Institute