Santé et fast data : le risque de la surinterprétation

L’exigence de la société pour des réponses instantanées impose une transformation toujours plus rapide des données brutes en connaissance. Cependant, dans le domaine de la santé, il y a quelques précautions à prendre. Pour comprendre les facteurs à risque, l’humain a encore toute sa place, comme l’explique Cyrille Delpierre, épidémiologiste à l’Inserm.

Par Paul Périé, journaliste scientifique.

Depuis très longtemps, l’épidémiologie, qui étudie les facteurs influant sur la santé des populations, doit traiter un grand nombre d’informations. L’arrivée de ce que l’on appelle le big data a donc simplement mis un nom sur cette énorme quantité de données auxquelles les chercheurs devaient faire face, comme le relève Cyrille Delpierre. Le fast data, quant à lui, impose de renforcer la méthodologie d’analyse des résultats des enquêtes.

Ce chercheur s’intéresse tout particulièrement aux origines des inégalités sociales en santé et aux solutions possibles pour les réduire. « On sait qu’il existe un écart de 6 ans d’espérance de vie entre un ouvrier et un cadre en France. Et si l’on prend les groupes les plus favorisés et les plus défavorisés du pays, l’écart est de 13 ans, ce qui est énorme. » Afin de comprendre cette disparité, il utilise ce qu’il appelle des données de cohorte, c’est-à-dire des informations provenant de personnes suivies au long cours et pour lesquelles un certain nombre de caractéristiques communes sont collectées, le recul pouvant être de 50 à 60 ans dans certaines cohortes de naissance.

Au-delà du volume de données collectées, la capacité et la vitesse de traitement deviennent primordiales

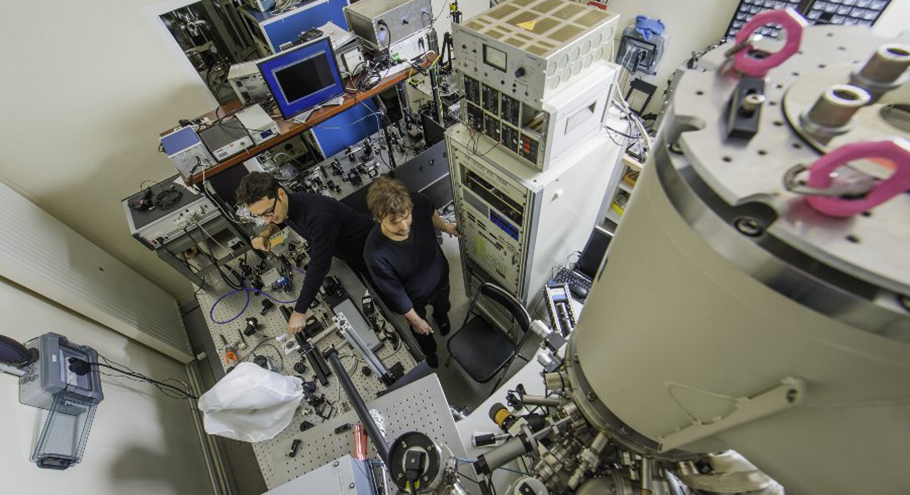

« Nous travaillons sur des données issues de personnes nées en 1958 au Royaume-Uni, ce qui nous donne aujourd’hui 14 000 variables : analyse sanguine, alimentation, milieu social, air respiré, zone de vie, environnement, travail… Toutes ces données, c’est du big data. Le fast data renvoie plus au fait de générer rapidement toutes ces données. Une fois que l’on a ces données, on essaye de voir comment tout cela est interconnecté. C’est le but de nos travaux », explique Cyrille Delpierre, chercheur Inserm au laboratoire d’ « Épidémiologie en santé publique : risques, maladies chroniques et handicaps ».

C’est ainsi que Cyrille Delpierre met en évidence la spécificité de ces analyses dans son domaine de recherche. « Le big data, le fast data, le smart data sont très particuliers en matière de santé. Il faut réfléchir aux croisements de données possibles, à leur apport, cela n’a rien d’automatique. Ce qui est vrai pour un usage commercial ne l’est pas forcément pour un usage dans le champ de la santé », éclaire le chercheur.

Trouver l’angle d’analyse et trier les données utiles

L’avènement du fast data a donc surtout permis d’avoir une vraie efficacité dans l’obtention rapide des données. Mais dans leur traitement, les choses sont différentes. « Aujourd’hui, on peut mesurer le rythme cardiaque 24 heures sur 24, 7 jours sur 7, et récupérer les données en temps réel. Sauf que personne n’a appris la physiologie cardiaque comme ça, avec des données massives produites en continue. On a donc de nouvelles informations sans trop savoir ce qui est normal ou pas. Le flot de données est de plus en plus important et de plus en plus rapide et cela questionne nos capacités d’analyse », décrypte Cyrille Delpierre.

Au-delà de l’aspect technique sous-jacent, c’est davantage l’angle d’analyse que souligne le chercheur de l’Inserm. Comment analyser ces données ? Avec quelle stratégie ? Qu’est-ce que cela peut apporter de pertinent en matière de santé ? Si la connaissance accumulée est énorme, celle-ci n’est pas toujours utile. Il faut en effet s’interroger sur l’origine de ces informations, sur leur validité dans un cadre donné, sur le but recherché, sur les liens de causalité.

Multiplier les regards autour des données produites

Pour bien comprendre de quoi il est question, il faut s’intéresser de plus près aux recherches menées par Cyrille Delpierre. Avec d’autres épidémiologistes, il fait partie de l’Institut fédératif de recherche interdisciplinaire sur les inégalités sociales de santé (Iferiss). Formés aux statistiques, les épidémiologistes travaillent en relation très étroite avec des spécialistes d’autres disciplines, qu’il s’agisse de mathématiciens, de data scientists, de sociologues, de politistes, de démographes… « La vraie différence avec l’émergence du big data et du fast data, c’est que cela décloisonne énormément les choses. Pendant très longtemps, on avait d’un côté des données biologiques et des données sociologiques qui ne se parlaient pas. Aujourd’hui, elles sont traitées tellement vites et facilement accessibles que l’on peut les croiser. C’est là que nous avons besoin de multiplier les regards autour des données produites. Nous sommes alors davantage dans le slow data. » À ses yeux, le big et fast vont forcément avec le smart et le slow, où l’humain est indispensable. C’est la vraie plus-value, car la donnée est aujourd’hui saisie de manière quasi-automatique.

Attention aux corrélations hâtives

La multiplication des données et l’accélération dans leur traitement présente même certains risques selon Cyrille Delpierre. En premier lieu, à une époque où l’on cherche des réponses simples et rapides, les chercheurs font face au danger de la surinterprétation. En croisant des données, on peut rapidement arriver à des conclusions qui tiennent davantage de la corrélation que de la causalité. « On assiste aujourd’hui à une remise en cause importante de nombreux résultats dans le champ de la santé (par exemple, à propos des vaccins). Et, rapidement, le croisement d’informations va potentiellement augmenter les liens statistiques entre de multiples expositions et de nombreuses maladies. Mais toutes les variables pertinentes auront-elles bien été prises en compte ? C’est là que l’épidémiologiste doit avoir en tête ces limites-là », insiste Cyrille Delpierre. Son vrai métier est notamment de hiérarchiser l’information et de questionner la causalité et de ne surtout pas céder à la tyrannie de l’instantanéité. Prendre le temps pour ne pas avancer de conclusions erronées qui pourraient avoir des conséquences graves.

L’épidémiologie, c’est quoi exactement ?

« Nous sommes des lanceurs d’alerte par définition. On le fait avec une approche scientifique connues, définie et reproductible. Nous nous exposons au fait d’être contredits. Tout est dans la méthodologie pour arriver à des conclusions pertinentes. » Cyrille Delpierre travaille sur des personnes nées en 1958 au Royaume-Uni. Cela s’explique par la législation particulière qui entoure les données en France, notamment avec la Cnil, mais surtout par un facteur historique. Pays très développé dans la médecine curative, la France ne s’est pas trop intéressée à l’aspect prévention en population générale. « Or, suivre une cohorte de populations, c’est suivre des gens quand ils n’ont rien pour récupérer des informations qui peuvent potentiellement être intéressantes. Cela a un coût », relève le chercheur. Parmi les premiers résultats, les recherches menées par son équipe ont montré que le fait d’avoir grandi dans un environnement hostile ou d’avoir été soumis à des stress forts et chroniques (être placé enfant en foyer ou avoir des parents ayant des addictions à des substances psycho-actives, par exemple) est associé à un risque plus élevé en moyenne de mourir avant 50 ans. « Le risque est également plus élevé de déclarer un cancer. Mais cela n’a rien de déterministe à l’échelle individuelle, insiste Cyrille Delpierre. C’est intéressant au niveau politique car on sait quels groupes de population il faut privilégier en matière de prévention. » Les épidémiologistes peuvent travailler en utilisant deux types de démarche. La première est dite « data driven », c’est-à-dire que les chercheurs n’ont pas d’hypothèse a priori et partent des données existantes. Dans le deuxième cas, ils ont une hypothèse et testent un modèle conceptuel dans les données disponibles.