Supercalcul : comment gérer l’abondance exponentielle de données ?

Atout considérable pour la recherche toulousaine, le supercalculateur Olympe, qui équipe le centre de calcul CALMIP illustre localement l’enjeu technologique et géopolitique des big et fast data. Aujourd’hui, il fournit une quantité de données incroyable qu’il faut valoriser au mieux.

Par Paul Périé, journaliste scientifique.

Dans la société actuelle, le sentiment partagé est que tout s’accélère. C’est aussi le cas dans le domaine de l’informatique, puisque les ordinateurs ne cessent de faire des progrès en matière de vitesse de calculs, créant toujours plus de données mais facilitant également leur exploitation. Aujourd’hui, le mot « supercalculateur » dans un outil de recherche vous mène rapidement à des articles annonçant la mise en service du plus important supercalculateur du monde, sur un classement ou sur le retour dans la course de tel ou tel pays. En juin dernier, Total a par exemple mis en production Pangea III, d’une capacité de 31,7 pétaflops, (floating-point opérations per second) « le premier calculateur de l’industrie mondiale » selon le groupe pétrolier. Derrière cette communication importante se cache un véritable enjeu technologique et géopolitique. « Dans le Top 500 des supercalculateurs, il y a certaines machines chinoises qui ont été mises en service pour réaliser tel type de calcul et intégrer ce classement. C’est un message envoyé aux États-Unis », décrypte Nicolas Renon, responsable d’exploitation du CALMIP. Dans cette course, le Japon est historiquement très bien placé en raison de son intérêt pour les mouvements terrestres. « Ils veulent simuler les tremblements de terre de manière très précise. C’est un exemple d’impact sociétal direct d’un pays qui va investir des milliards dans une machine pour sauver des vies. »

Une croissance exponentielle des données créées

En 2018, 33 zettaoctets (1021 octets) de données numériques ont été créées dans le monde, selon la dernière édition du Statista Digital Economy Compass. Ce même rapport estime que l’on devrait atteindre les 2 100 zettaoctets en 2035. Des chiffres difficiles à appréhender mais qui illustrent parfaitement l’explosion de la quantité de données générées. Aujourd’hui, plus personne ne peut s’en passer et leur valeur est de plus en plus grande. Mais, plus important encore, l’analyse de ces données est devenue un véritable enjeu stratégique. Pour les entreprises comme pour les chercheurs, la capacité d’acquérir de la connaissance à partir de ces données en temps réel, ce que l’on appelle le fast data, est primordiale.

Une explosion de la vitesse de calcul au service de la recherche

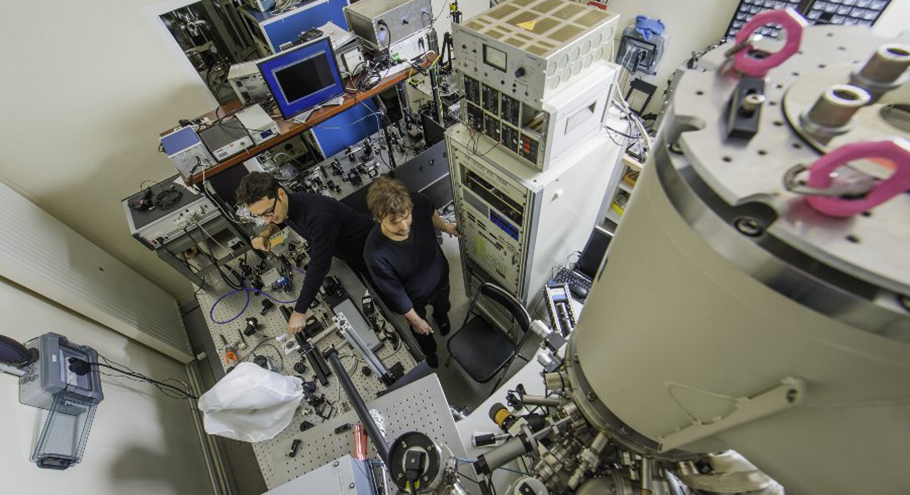

Toulouse dispose aussi de son supercalculateur, même s’il n’a rien de comparable avec ce type de machines.

« Nous sommes un mésocentre de calcul. C’est une échelle intermédiaire entre les ordinateurs de bureau et les supercalculateurs de niveau européen ou national »,

indique Nicolas Renon, ingénieur de recherche à l’Université Toulouse III – Paul Sabatier

Depuis fin 2018, le CALMIP dispose d’un nouveau supercalculateur baptisé Olympe.

« Depuis Magellan, notre premier calculateur il y a 20 ans, la montée en puissance est phénoménale. Nous sommes passés de 0,04 téraflops à 1 365 téraflops avec Olympe »,

assure Nadine Marouzé, chargée d’affaires calcul scientifique.

CALMIP doit rester compétitif, car cet outil est en priorité mis à disposition de 45 laboratoires de recherche, mais aussi de PME et PMI qui ont des projets de recherche.

« L’idée est d’aider les utilisateurs à accéder à ces ressources de calcul et de mettre en relation entreprises et laboratoires pour tendre vers le transfert de technologie »,

précise Nicolas Renon.

Des heures de calcul pour simuler des phénomènes physiques

Aujourd’hui, deux secteurs d’activité, représentatifs du tissu industriel toulousain, concentrent plus de la moitié des heures de calcul d’Olympe : la physico-chimie des matériaux et la mécanique des fluides. Viennent ensuite les sciences de l’univers et la chimie. Et la demande est supérieure aux capacités du supercalculateur. L’objectif est généralement de simuler numériquement, via des formules mathématiques, des problématiques physiques telles que les mouvements d’air autour d’une aile d’avion. Cela permet de créer des modèles prédictifs qui font gagner un temps considérable. Mais derrière ces prouesses se cache une technologie de pointe.

Optimiser la communication entre les données

La réalisation de supercalculs implique nécessairement des calculs parallèles. En effet, le travail est réparti sur des milliers de processeurs, de manière équitable. Mais, dans le même temps, l’utilisation d’algorithmes parallèles nécessite des échanges permanents d’informations entre les différentes unités de calcul. « On a donc à faire à deux processus contradictoires : le partage de travail qui accélère la vitesse de calcul et la communication qui vous impose de vous arrêter de travailler pour échanger de l’information, analyse Nicolas Renon. Ce que vous gagnez d’un côté, vous le perdez de l’autre. Il faut trouver à la fois la machine qui permet de communiquer le plus vite possible et les algorithmes qui font qu’il y a moins de communication… »

Une valorisation essentielle de la donnée

Afin de tester les capacités d’Olympe, le supercalculateur a été dédié à un seul projet autour de la fabrication du plastique pendant un mois. Une première mondiale sur un cas industriel et un calcul qui a nécessité 5 millions d’heures de travail et généré 160 teraoctets de données. Des données directement utilisables par les chercheurs dans ce cas. Mais, alors que le calcul haute performance existe depuis une trentaine d’années, la quantité de données produites est énorme et l’une des grandes questions aujourd’hui est celle de leur valorisation. Pour cela, la capacité de traitement des supercalculateurs se déploie afin d’utiliser ce grand volume de données.

Face à l’afflux massif de données et à leur génération toujours plus rapide, les différents projets de recherche doivent aujourd’hui prendre en compte les principes FAIR (trouvable, accessible, interopérable et réutilisable). L’utilisateur a ainsi l’obligation de réfléchir en amont de son calcul à ce qu’il va advenir de la donnée générée. Il faut se positionner dans une perspective de réutilisation et de partage de cette donnée.

« Le Data Management Plan (DMP), ou plan de gestion de la donnée, est une partie intégrante des projets de recherche qui nécessitent du supercalcul. Nous sommes justement en train de nous positionner dans l’accompagnement de la rédaction de ces DMP »,

note Nadine Marouzé.

La problématique du stockage des données, qui a un coût et un impact environnemental conséquent, a accéléré ce besoin de qualification et de valorisation de la donnée.

CALMIP : CAL pour calcul et MIP pour ex-Midi-Pyrénées, mésocentre sous la tutelle de l’Université fédérale Toulouse Midi-Pyrénées, du CNRS, de Toulouse INP, de l’Insa, de l’Isae-Supaero et de l’Université Toulouse III - Paul Sabatier