Comment éviter que l’intelligence artificielle devienne une menace pour la démocratie ?

Transparence, égalité et non-discrimination … Encadrer l’usage de l’IA est indispensable pour garantir ces principes démocratiques fondamentaux. La juriste Céline Castets-Renard et le mathématicien Jean-Michel Loubes conduisent ensemble des projets pour comprendre les problématiques juridiques liés aux traitements des données. Ils cherchent à déceler et corriger les biais des algorithmes et contraindre le pouvoir des statistiques. Un entretien croisé à découvrir dans Investiga’Sciences.

Par Valérie Ravinet, journaliste. Podcast enregistré le 31 mars 2020 à Toulouse.

Morceaux choisis

A l’origine de la collaboration

Céline Castets-Renard : « Une attention partagée sur l’utilisation des données personnelles, qui s’est élargie à une réflexion sur l’utilisation de l’IA pour servir des principes juridiques fondamentaux, comme l’égalité et la non-discrimination. Nous avons construit un corpus autour de cette exigence ».

Un exemple

CCR : « Une étude sur la police prédictive, conduite aux Etats-Unis. Des outils y sont déployés, souvent par des entreprises privées, pour identifier des endroits à risques -vols, criminalité- et favoriser le déploiement des patrouilles par anticipation. Les bases de données utilisées dans ce type d’outils sont biaisées et visent des quartiers où résident essentiellement des populations afro-américaines et latino. Il y a là un problème démocratique qui exige de la transparence sur les outils utilisés. La législation française tend d’ailleurs vers cette exigence par rapport aux outils qui prend des décisions automatiques ».

Une définition de l’IA

Jean-Michel Loubes : « L’IA est un ensemble de techniques permettant à des machines d’accomplir des tâches en essayant de simuler le fonctionnement d’un raisonnement humain. Ces techniques sont notamment basées sur des modèles, ou règles, auxquels on a adjoint des méthodes d’apprentissage automatique utilisant un grand nombre de données ».

L’importance de la donnée

JML : « L’algorithme façonne la réalité puisqu’il ne traduit que ce qu’il apprend. Les corrélations induites, sur la base des données à partir desquelles la machine a appris, ont un impact très important dans le traitement équitable entre les personnes, puisqu’elles généralisent des erreurs. Il s’agit donc de détecter ces biais et de fournir de nouveaux modèles mathématiques pour quantifier les problématiques juridiques et corriger les prédictions de l’IA lorsque les données ne reflètent qu’une réalité partielle. »

Les risques

CCR : « En droit, le principe d’égalité se traduit par la lutte contre la discrimination, dont on sait qu’elle est particulièrement présente, par exemple, sur le marché du travail, dans le logement. Les juristes dénoncent ces biais pour faire respecter la loi ».

Quelles normes adopter ?

CCR : « En matière d’IA, les normes sont souvent d’origine privée. Attention à ce que les Etats gardent le contrôle des technologies et dans l’adoption des normes ».

À propos des intervenants

Céline Castets-Renard est spécialiste en droit du numérique et intelligence artificielle. Elle est aujourd’hui professeure à l’Université d’Ottawa et titulaire de la chaire « Droit, responsabilité et confiance sociale en intelligence artificielle » au sein de l’Institut interdisciplinaire d’intelligence artificielle de Toulouse, ANITI. À l’Université Toulouse 1 Capitole, elle a fondé et co-dirigé le master Droit du numérique. En 2015, elle a été nommée membre de l’Institut Universitaire de France (IUF).

Elle est à l’origine de plusieurs séminaires dont « Intelligence artificielle et Algorithmes », « Données personnelles » ou encore « Sécurité des données et systèmes d’information » ; son programme de recherche porte sur la régulation du numérique dans des domaines variés.

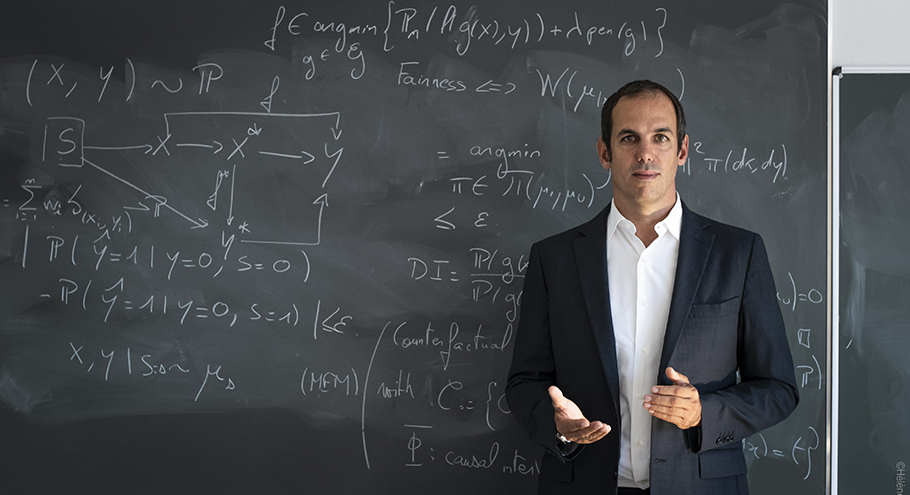

Jean-Michel Loubes est enseignant-chercheur de l'Université Toulouse III - Paul Sabatier, rattaché à l’Institut de mathématiques de Toulouse (IMT) dans le domaine des probabilités et des statistiques appliquées. Expert en intelligence artificielle, spécialité apprentissage automatique, il est titulaire de la chaire « fiabilité et robustesse des méthodes d’apprentissage automatique » de l’institut interdisciplinaire d’intelligence artificielle de Toulouse, ANITI. Il est également à l’origine de la création de l’Agence pour les mathématiques en interaction avec l’entreprise et la société, AMIES, qui s’inscrit comme médiateur pour intervenir en entreprise en mobilisant des mathématiques innovantes. Il est actuellement Vice-président de l'Université Toulouse III - Paul Sabatier, Délégué à l'innovation pour l'industrie.

Écoutez Investiga' Sciences #1

À propos d’Investiga’Sciences

Investiga’Sciences est une série de podcasts scientifiques, dont l’objectif est d’explorer un sujet avec deux experts, dans un débat au long cours. Chaque épisode est dédié à un thème et croise les regards et les expériences pour comprendre ses enjeux, ses défis, ses perspectives. Créé par la journaliste Valérie Ravinet, ce projet est soutenu par ANITI et l’Université fédérale Toulouse Midi-Pyrénées. Ont contribué à la réalisation de cet épisode : le dessinateur Ström pour le visuel, le Studio du Cerisier pour la prise de son et le jingle.