Police prédictive : un cadre et une nécessaire transparence

La massification des données, l'accélération de leur collecte et de leur analyse donnent lieu depuis quelques années au développement d'outils basés sur l'intelligence artificielle (IA), destinés à faire des prédictions à des fins très diverses : commerciales, médicales... voire policières. Des travaux de recherche montrent qu'il faut prendre le temps de poser un cadre et d'expliquer les traitements algorithmiques si on veut éviter des dérives techniques et juridiques.

Par Camille Pons, journaliste scientifique.

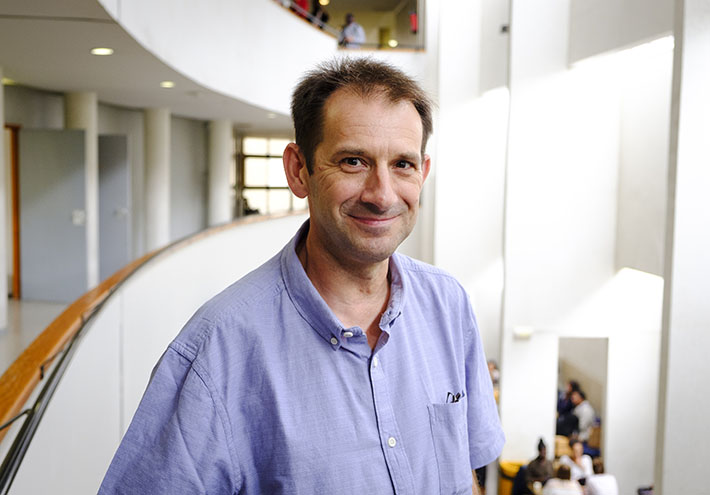

La police prédictive, c'est quoi ? Minority Report ? Tom Cruise chassant, en 2054, des personnes dont trois extra-lucides prédisent leurs crimes à venir et en transmettent les images à la police du futur ? « Non, en France, on en est très très loin ! On prédit des choses plutôt modestes », s'amuse Laurent Perrussel, enseignant-chercheur à l'Université Toulouse 1 Capitole, spécialisé dans le domaine de l’IA. Pour autant, la « police prédictive » existe. Elle consiste à utiliser des données et autres indicateurs pour calculer la probabilité du risque de survenance d'un crime ou délit dans le futur -calcul fait par un algorithme, donc une machine et non un extralucide - et appuyer certaines missions des policiers.

En France, contrairement aux États-Unis, ces analyses prédictives ne concernent pas les individus. Aucun calcul de probabilité qu'une personne, précédemment repérée en raison d'activités suspectes, puisse passer à l'action, n'est réalisé. L'objectif est de cibler des lieux. Les outils auxquels on s'intéresse pourraient permettre d'organiser de manière plus optimale certaines activités comme la gestion des appels d'urgence, des crises, de la lutte contre la fraude ou encore le déploiement des forces de police. Comment ça marche ?

« On prend par exemple des historiques liés à des délits, des vols de voiture par exemple, on ''combine'' avec des données géographiques, de l'INSEE (Institut national de la statistique et des études économiques), et on crée des cartes de chaleur [cartes où les informations sont rendues visibles par un code couleurs facilement compréhensible, du rouge pour une forte activité au bleu pour une faible activité] ce qui peut permettre de mieux organiser les patrouilles »,

explique Laurent Perrussel.

Pour autant, si l'intention peut être « louable », l'utilisation de ces outils n'est pas sans risques, au regard des libertés fondamentales, mais pas seulement.

« En police prédictive, s'il y a un biais dans les données au départ, l'apprentissage automatique va renforcer ce biais »,

précise le chercheur.

Par exemple, dans le cas d'outils conçus en s'appuyant sur des historiques, l'algorithme a tendance à renforcer le biais observé. Ce qui s'était déjà vu lors de l'utilisation d'un outil prédictif de recrutement mis au point en 2014 par Amazon : il discriminait les femmes. Parce que les CV reçus par le groupe sur une période de dix ans et utilisés pour « entraîner » le logiciel reflétaient la prédominance masculine dans le secteur des nouvelles technologies. « Dans le cas d'Amazon, l'outil partait avec davantage de données de candidats masculins. Résultat, si on part d'une réalité, l'algorithme la reproduit », prévient Laurent Perrussel.

Veiller à la qualité des données en entrée

Des limites qu'un récent programme de recherche auquel Laurent Perrussel était associé a mis en avant. Ce travail, financé par le Centre des hautes études du ministère de l'Intérieur (CHEMI), a permis de fournir des recommandations pour mieux encadrer les risques techniques et juridiques de la police prédictive. Cette recherche, pilotée par une chercheuse également de l'Université Toulouse Capitole, Céline Castet-Renard, s'est appuyée sur l'analyse des outils utilisés aux États-Unis et en Europe. L'impact sur la population a également été mesuré, en tenant compte de cadres légaux très différents. Ce travail a donné lieu à un rapport, rendu au printemps 2019.

Veiller à la qualité des données en entrée, celles avec lesquelles l'algorithme va s'entraîner, compte d'ailleurs parmi les principales recommandations des chercheurs qui invitent à prendre des précautions à plusieurs niveaux. Tout d’abord, la législation, en l’occurrence le Règlement général sur la protection des données (RGPD), encadre l’usage des données personnelles : on ne peut utiliser des données personnelles sans consentement et la prise de décision automatique exploitant ces données est aussi délimitée. Ensuite, on ne peut non plus utiliser des données et témoignages dont la provenance, la véracité et la fiabilité ne sont pas certaines, et, en dehors des données émanant de la police que l'on peut légitimement utiliser (sous réserve de respecter les règlementations), passer des contrats avec les titulaires des données en question...

Allier quantité et qualité des données pour bien « entraîner » l’algorithme

Cette qualité est indispensable au regard d'écueils déjà observés sur des outils prédictifs. En 2015, un algorithme de reconnaissance faciale du géant américain Google avait identifié des Afro-américains comme des gorilles. En 2018, l'Union américaine pour les libertés civiles (ACLU) avait testé le même type de logiciel (développé par Amazon), en demandant de comparer le visage des membres du Congrès à une base de données de 25 000 criminels recherchés. Sur les 535 élus, 28 personnes avaient été identifiées comme des criminels, soit 5 % de faux « matches », alors que la police d'Orlando, en Floride, utilisait déjà cet outil.

« Ce n'est pas l'algorithme qui est en cause, mais la qualité des données utilisées, ainsi que la quantité utilisée pour l'apprentissage de la machine (ou machine learning) »,

poursuit Laurent Perrussel.

En effet, pour que l'algorithme soit bien « entraîné » et puisse correctement interpréter, il faut lui fournir une très grande quantité de données. « Par exemple, pour l'interprétation d'images, un humain pourra déduire qu'il s'agit d'un oiseau en repérant les caractéristiques propres à celui-ci : des ailes, un bec, la ponte d'œufs, etc. Pour la machine, il s'agit de lui ̎ passer ̎ des milliers d'images et de lui indiquer ̋ là il s'agit d'un oiseau, là, ça n'en est pas un, etc.̋ », explique Laurent Perrussel.

L'« explicabilité » : un enjeu majeur

Le rapport insiste aussi sur l'importance de travailler sur l'« explicabilité » et c'est d'ailleurs la recommandation n°1 : renforcer les exigences légales de transparence algorithmique et d’« explicabilité ». Exigence déjà dans la loi pour tout traitement algorithmique utilisant des données personnelles mais qui devrait, selon les chercheurs, s'étendre aussi à la mise en œuvre d'algorithmes utilisant aussi des données non personnelles. Il faudrait également, selon eux, aller « au-delà des exigences légales », comme publier ces données et leurs caractéristiques, ainsi que l'évaluation des risques et méthodes utilisées pour atténuer les biais potentiels.

Une exigence qui s'applique d’ailleurs à tout domaine de l'IA, encore entourée de grands mythes et mal comprise. Ces projets suscitent aussi de forts enjeux en terme d'acceptabilité sociale. Comprendre comment ça marche, quelles sont les techniques d'apprentissage automatique, les techniques de raisonnement... permet ainsi « de se rendre compte que ce n'est pas de la magie et de ce que l'on peut demander à la machine », poursuit Laurent Perrussel. Expliquer, c'est aussi donner au public confiance en ces outils. Enfin, autre enjeu, expliquer peut permettre d'influer positivement sur les décisions, car l'algorithme (choix des données, du calcul, etc.) est bel et bien le fruit de décisions politiques, sociales, éthiques, économiques... donc prises par des humains.

« C'est là que notre travail peut apporter au quotidien : la culture des données et des algorithmes. C'est une fois que l'on a bien compris la culture numérique que l'on sait quelles opportunités on peut saisir ! »

conclut Laurent Perrussel.

Découvrir un chercheur par la radio : tel est le challenge de la chronique Cap sur les labos. Cette émission hebdomadaire vous emmène à la rencontre de la vie de la recherche. A chaque podcast : un chercheur présente ses projets avec leurs lots d’enjeux, d’envies et d’espoirs. Écoutez Laurent Perrussel dans ce podcast réalisé par Vincent Ducasse et Philippine Le Maguer. Cap sur les labos est diffusé sur Campus FM Toulouse, 94 MHz, à 11 h le lundi et 15 h le mardi.