Éthique : morale humaine pour intelligence artificielle ?

Les progrès en intelligence artificielle promettent des voitures autonomes aux capacités techniques très avancées. Capable de décider seule du meilleur trajet à suivre, pourrait-elle choisir la destination du passager sans son accord ? Si une voiture autonome connait le code de la route sur le bout des roues, qu’en est-il de son code moral ?

Par Dana Pizarro, chercheuse à l’Institut interdisciplinaire d’intelligence artificielle de Toulouse (ANITI - Artificial and Natural Intelligence Toulouse Institute) à la Toulouse School of Economics - Research

Si l’avancement des recherches et techniques concernant l'intelligence artificielle (IA) est important, les préoccupations éthiques qui les accompagnent le sont tout autant. De la perte d’emploi dans les secteurs où l’automatisation se développe, au droit des robots, en passant par les décisions prises par les véhicules à conduite autonome, ces questionnements sont nombreux.

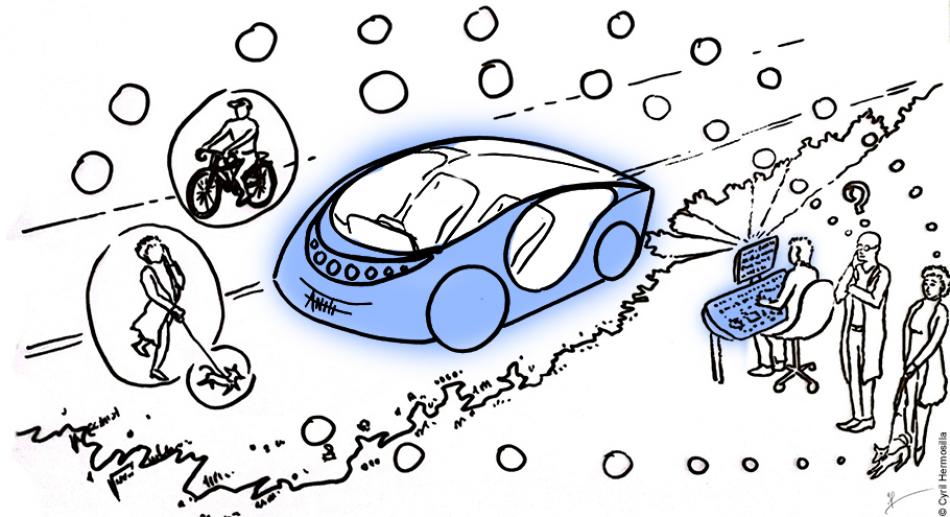

La création de machines et systèmes qui remplacent les actions et la prise de décision humaines est l’une des applications les plus populaires de l'intelligence artificielle. Les voitures autonomes sont par exemple capables d’imiter les capacités de conduite humaine et se passent ainsi de conducteur.

Cependant, que se passe-t-il lorsqu'une telle voiture doit prendre une décision qui implique un possible préjudice matériel ou humain ? C'est là que l'éthique, les questions de jugements et critères moraux entrent en jeu. Prendre en compte l'éthique en IA revient à créer et intégrer des normes et règles de sécurité pour encadrer le comportement moral des machines intelligentes et prévenir les risques liés à leur utilisation.

Programmer des choix éthiques ?

Supposons qu'une voiture autonome circule sur une route, lorsqu'elle remarque qu'un piéton la traverse subitement. Dans cette situation, la voiture a deux possibilités. Soit elle heurte le piéton, entraînant des dommages mineurs à la voiture. Soit elle évite le piéton et heurte un arbre, ne blessant personne, mais abîmant fortement la voiture.

La voiture répond à la manière dont elle a été programmée. Elle n’est pas capable d’effectuer une analyse éthique de la situation avant de prendre une décision. Il est donc important que toutes les situations soient prises en compte dès sa création et sa programmation. En effet, si la voiture est programmée pour « minimiser les dommages mécaniques », elle heurtera sans aucun doute le piéton !

Lorsque la situation impose de choisir entre vies humaines ou pertes matérielles, la réponse éthique est simple. Mais il existe des cas moraux et éthiques beaucoup plus complexes, surtout lorsque la situation impose de choisir entre plusieurs vies humaines. Que se passe-t-il si la voiture doit sauver deux passagers ou trois piétons ?

Code de la route et code moral

Pour se pencher sur ces questions éthiques, le dispositif « Moral Machine » a été créé par Jean-François Bonnefon, chercheur responsable de la chaire « IA morale » de l’Institut interdisciplinaire d’intelligence artificielle de Toulouse (ANITI - Artificial and Natural Intelligence Toulouse Institute).

Différents dilemmes moraux y sont présentés à des citoyens sous la forme d'un jeu dans lequel une voiture autonome doit choisir entre le moindre de deux maux. L'objectif de cette plateforme est de connaître le point de vue d’humains sur les décisions morales qui devraient être prises par une machine intelligente. Le code de la route étant déjà intégré par la voiture, il s’agit de l’alimenter d’un code moral inspiré par les décisions humaines.

Illustration de Cyril Hermosilla